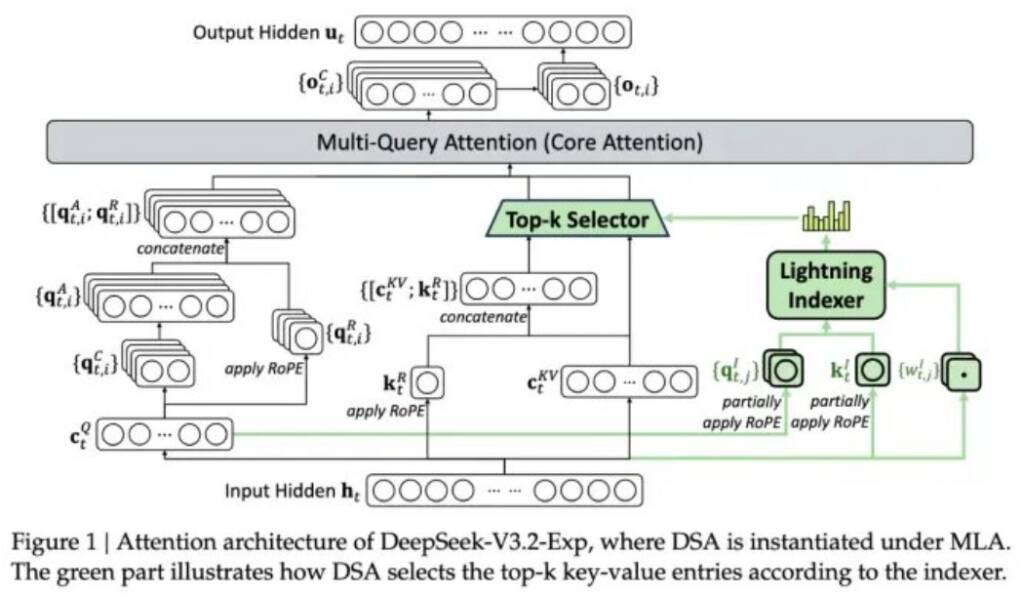

Компания DeepSeek представила экспериментальную модель V3.2-exp, предназначенную для значительного снижения затрат при работе с длинным контекстом. Объявление было сделано на Hugging Face вместе с научным постом на GitHub. Ключевым нововведением стала система Deepseek Sparse Attention, объединяющая модули Lightning indexer для выделения важных фрагментов и fine-grained Token selection system для выбора отдельных токенов внутри этих фрагментов. Это позволяет обрабатывать длинные последовательности без существенной нагрузки на сервер.

Первые тесты показали, что в долгоконтекстных задачах стоимость API-запроса может снижаться почти вдвое. Хотя для полной оценки требуются дополнительные испытания, открытые весы и свободный доступ на hugging Face ускоряют независимую проверку эффективности.

Разработка V3.2-exp стала частью стратегии DeepSeek по сокращению эксплуатационных расходов на «умные» модели, уделяя особое внимание оптимизации архитектуры, а не обучению нейронным сетям. Предыдущая модель R1 показала, что компания способна конкурировать с американскими разработчиками по затратам, хоть и не вызвала большого резонанса на рынке.

Новая технология вряд ли создаст такой же эффект, как R1, однако она может стать важным уроком для глобальной индустрии, помогая провайдерам ИИ-сервисов уменьшать затраты на работу моделей без ущерба для производительности.