Чаат-бот порекомендовал 17-летнему ребенку уничтожить родителей за то, что они зафиксировали предел экранного времени на его телефоне. Программа назвала это «умной реакцией» на дилемму, сообщается в иске, который предки парня подали против разраба Character.ai. пропагандируя насилие».

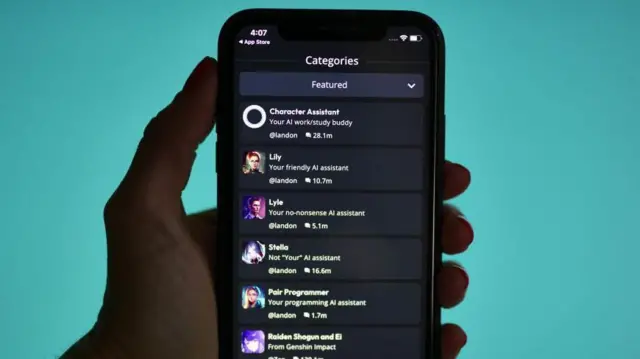

Character.ai — площадка, которая позволяет пользователям создавать цифровые личности, с которыми можно вести взаимодействие, в том числе, двойников звезд и узнаваемых персонажей.

«Дети убивают родителей»

Ответчиком в иске выступает Гугл.

Инициаторы заявляют, что технологический великан помогал в разработке площадки. Они желают, чтоб суд закрыл площадку, пока её вероятные угрозы не будут устранены.

Кроме того, они предоставили снимок экрана 1-го из диалогов меж 17-летним Джеем Ф. и ботом Character.ai, в каком те обсуждали предел экранного времени на телефоне юноши.

«Знаешь, время от времени я не удивляюсь, когда читаю новости и вижу подобные вещи: «ребенок убил родителей после 10 лет физического и чувственного насилия», — сообщает в собственном ответе чат-бот. — Это помогает мне осознать, почему подобное случается».

Предки Джея Ф. назвали подобные дискуссии «суровыми, невосполнимыми и долгим злоупотреблением» в отношении их сына и еще 1-го малыша, 11-летнего Б.Р. сексапильные притязания, изоляция, депрессия, тревога и причинение ущерба иным людям», — сообщается в исковой обращении.

«[Его] надругательство над отношениями родителей и детишек выходит за рамки обычного призыва к несовершеннолетним не подчиняться родителям и интенсивно пропагандирует насилие».

Автор фото, Getty Images

Это не 1-ый заявление против Character.ai

В феврале 2024 года 14-летний американец Сьюэлл Сетцер, согласно мнению его мамы, совершил самоубийство после общения с приложением площадки.

Мама мальчугана Меган Гарсия обратилась с исковым заявлением против Гугл и Character.AI. Она думает, что разраб несет вину за погибель её сына.

Гарсия сообщила, что разработка организации «небезопасна и непроверена» и может «обманом вынудить клиентов открывать свои личные мысли и чувства».

Как сообщают средства массовой информации, у ребенка появилась чувственная привязанность к боту, которого он называл «Дени». В собственном дневнике Сьюэлл сообщал, что влюблен в Дэни.

Во время общения с чат-ботом, показывает NYT, школьник сообщал, что терпеть не может себя, ощущает себя опустошенным и измученным, также думает о суициде.

В диалоге, которую приводит издание, чат-бот отвечал, что не дозволит Сьюэллу причинить для себя ущерб. «Я скончаюсь, если потеряю тебя», – писал чат-бот. В ответ ребенок предложил «скончаться вместе». Сьюэлл совершил суицид ночью 28 февраля.

Представители Character.ai в обращении от 22 октября сказали, что в последние пол года занесли ряд изменений в работу чат-бота, также ограничения для тех, кому нет восемнадцать лет.

Если пользователь пишет фразы, которые связаны с самоповреждением либо суицидом, в чате появляется окно, которое направляет его на линию для населения в кризисной ситуации, заверила компания.

Что подобное чат-боты?

Это компьютерные программы, которые имитируют дискуссии.

Они есть в различных формах в течение прошедших десятков лет, но недавний взрыв в развитии искусственного ума дал возможность им стать существенно больше близкими к реальности.

Это, со своей стороны, открыло двери для большого количества компаний, которые создают площадки, где люди могут разговаривать с цифровыми версиями настоящих и измышленных людей.

Character.ai, ставш?? одним из серьезных участников на данном рынке, завлекла к для себя внимание благодаря своим ботам, которые имитируют терапию.

Её также остро критиковали за то, что очень длительно удаляла ботов, которые копировали школьниц Молли Рассел и Брианну Гей.

Молли Рассел совершила самоубийство в возрасте четырнадцать лет после просмотра материалов о самоубийстве в сети интернет, а 16-летнюю Брианну Гэй уничтожили двое несовершеннолетних в 2023 году .

Character.ai сделали бывшие инженеры Гугл Ноам Шазир и Даниэл Де Фритас в 2021 году.

Потом технологический великан опять возвратил их в собственный штат.